In der letzten Zeit überschlagen sich die Entwicklungen im Bereich KI (Künstliche Intelligenz, im englischsprachigen Raum AI für Artificial Intelligence), so dass diese bereits auf viele Bereiche unseres alltäglichen Lebens zugreift – ob bei der Generierung von Informationen und Texten (Nachrichten, Bilder, Videos, Forschungsarbeiten u.v.m.), als Kontrollinstanz (Gesichtserkennung am Flughafen, Filter für Hass-Kommentare bei Sozialen Medien), als praktische „Helferlein“ (beispielsweise virtuelle Assistenz auf Webseiten, Telefon-Hotlines) und in der Unterhaltungsbranche (personalisierte Empfehlungen und Werbung bei Netflix, Amazon und Co.).

Daher kann es nicht verwundern, dass auch in unserem Feld der Wissensvermittlung zunehmend die Frage aufkommt, ob und wie sich KI einsetzen lässt, um beispielsweise Texte zu bearbeiten, Bilder zu generieren oder statische Abbildungen zu animieren. In unserer zukünftigen Projektarbeit soll dieser Bereich eine größere Rolle spielen – im Bewusstsein, dass solche KI-Anwendungen bei der Vermittlung von kulturellem Erbe ebenso Vorteile wie Risiken mit sich bringen. Ein paar Überlegungen dazu möchten wir im Folgenden mit Ihnen teilen:

Texte kürzen und neu perspektivieren

Eine typische Herausforderung in unserem Projekt ist es, vorhandene, meist lange Schrifttexte wie Ortschroniken oder Fachtexte von historischen Vereinen in ein passendes Format für KuLaDig oder für andere als die ursprünglichen Zielgruppen zu transformieren. Hier leisten Large-Language-Models wie ChatGPT inzwischen gute Arbeit, wenn man die betreffenden Texte in die Software lädt und mit Eingaben (Prompts) wie „Kürze den Text auf 10 Sätze.“ oder „Formuliere den Text um für die Zielgruppe [junge Menschen] [Touristen]“ etc. bearbeiten lässt. Gewiss muss man die Ergebnisse nochmals kontrollieren und nachbearbeiten, zumal solche Programme mitunter Fakten hinzuerfinden, da sie auf Wahrscheinlichkeitsberechnungen aufbauen. Wir erwarten hier aber eine Arbeitserleichterung für die Projektteams in den Kommunen bei der Texterstellung, vor allem, wenn es um eigene Textvorlagen geht.

Vertonung und Übersetzung von Texten

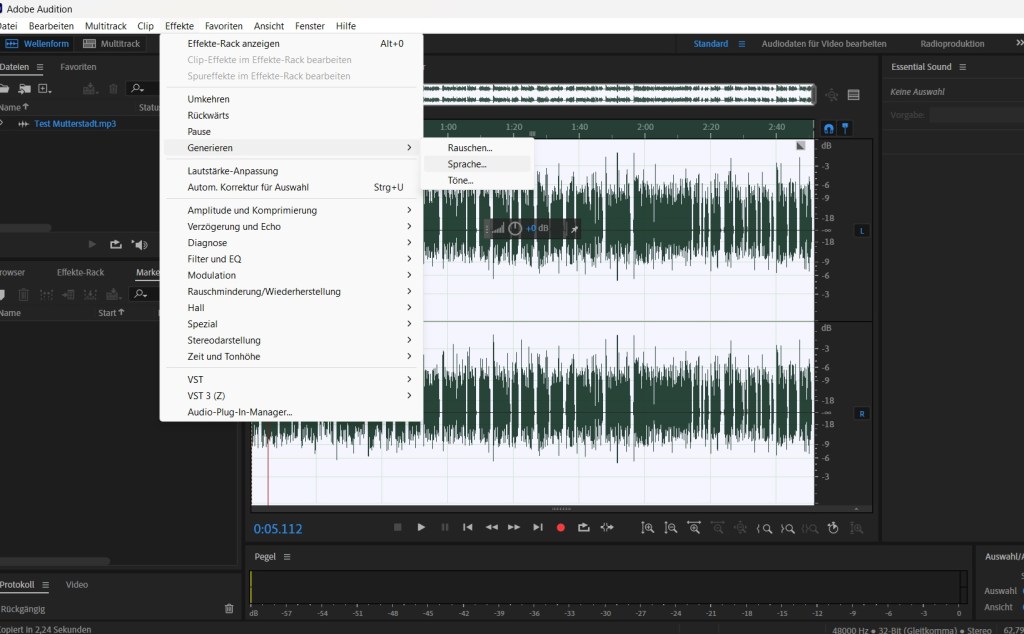

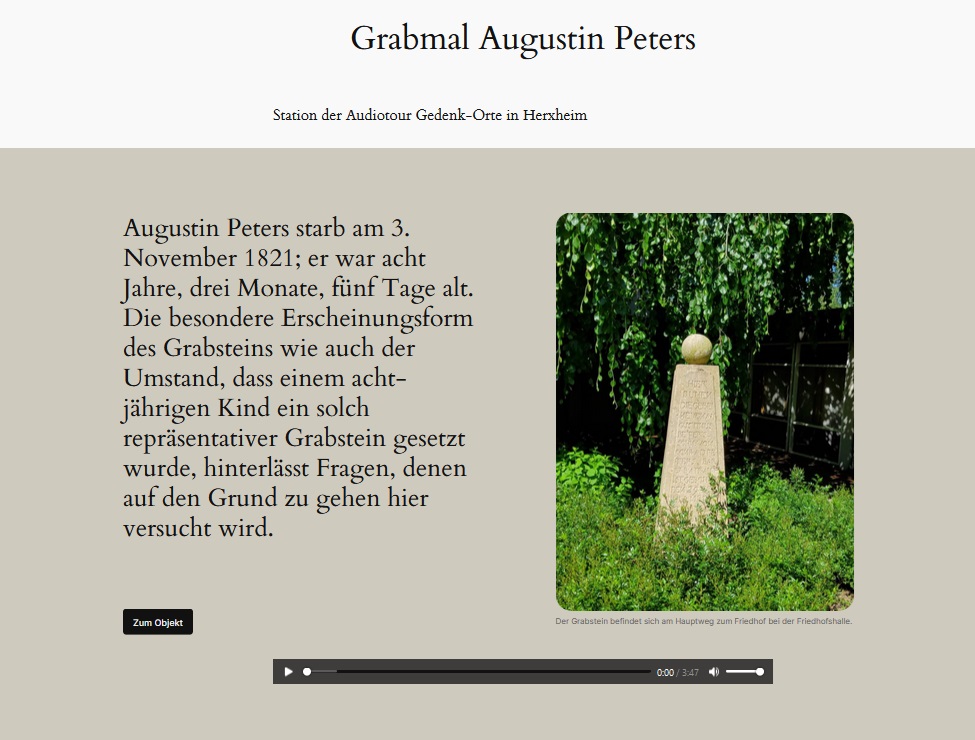

Die Informationsvermittlung setzt verstärkt auf Audiovisualität, da immer weniger Menschen bereit sind, lange Texte zu lesen, aber auch aufgrund erhöhter Anforderungen an Barrrierefreiheit von Websites etwa für sehbehinderte Personen. Insbesondere Audios erfreuen sich in unseren Teilprojekten großer Beliebtheit, da man zum Beispiel parallel zum Hören mit seinen Blicken die Umgebung erkunden kann. Ein Effekt, den man bereits von Audio-Guides aus Museen kennt und schätzt. Nun kann man mit dem Diktiergerät des eigenen Smartphones bereits gute Audios erstellen. Unsere Partner in Herxheim beispielsweise produzieren bei ihrem Grabstein-Projekt eine Vielzahl wunderbarer Audios, ganz ohne KI. Wenn man aber den Weg mit KI gehen möchte, gibt es dafür kostenfreie Möglichkeiten, wenn man nicht – wie in unserem Projekt – vorhandene Lizenzen wie etwa ein Adobe-Paket nutzen und ein Audio mit Adobe Audition, einer Software zur Bearbeitung von Audiodateien, produzieren kann. So haben wir zum Beispiel Audios für die Kirche Sankt Medardus in Mutterstadt mit künstlicher Stimme generiert.

Blick in die Bearbeitungsmaske von Adobe Auditions

Die Begrenzung der Zeichen auf 5000 macht deutlich, dass ein einfaches Überführen der eigenen Texte aus KuLaDig in die Software nicht die Antwort sein kann. Es bedarf einer Überarbeitung der Textversion in eine knappere Audioversion, die zudem Fremdwörter oder Abkürzungen vermeidet. Das Ergebnis überzeugt uns noch nicht ganz, da es zu wenig natürlich klingt:

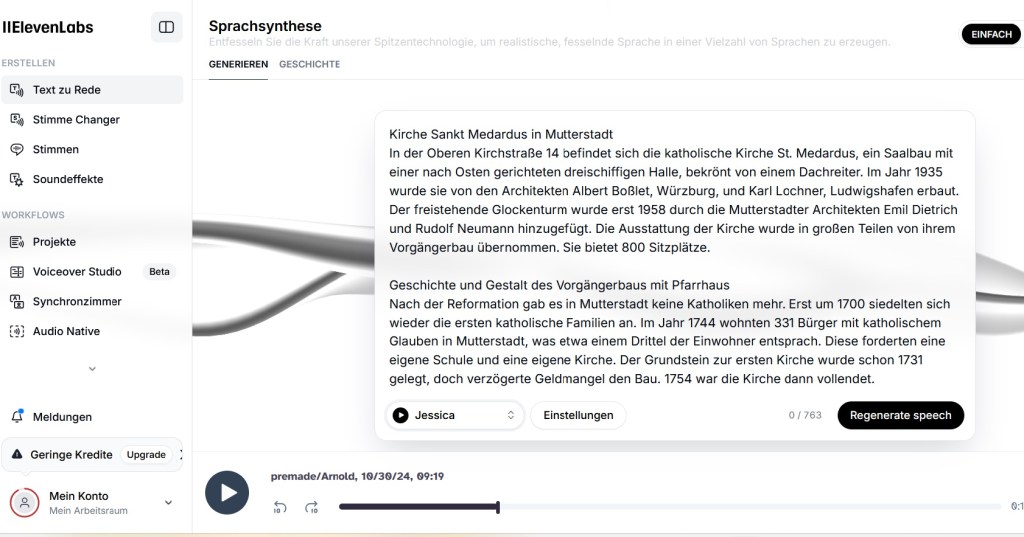

Ein Versuch mit der Software elevenlabs.io (https://elevenlabs.io) kommt unseren Erwartungen schon um einiges näher. Hier kann man den gekürzten Text in eine Maske eingeben und eine künstliche Stimme mit einem Profil nach Geschlecht, Alter etc. aussuchen kann. Wir haben uns für die KI-Stimme Jessica entschieden, die zwar etwas streng, aber doch einigermaßen natürlich daherkommt:

Die generierte Datei kann dann heruntergeladen werden. Die Nutzung von elevenlabs erfordert, dass man sich zuerst registrieren muss. Zudem kann man mit der kostenlosen Variante nur eine bestimmte Anzahl von Dateien produzieren. Aber für ein Kennenlernen der Software und für ein Produzieren erster eigener KI-generierter Audios reicht es völlig.

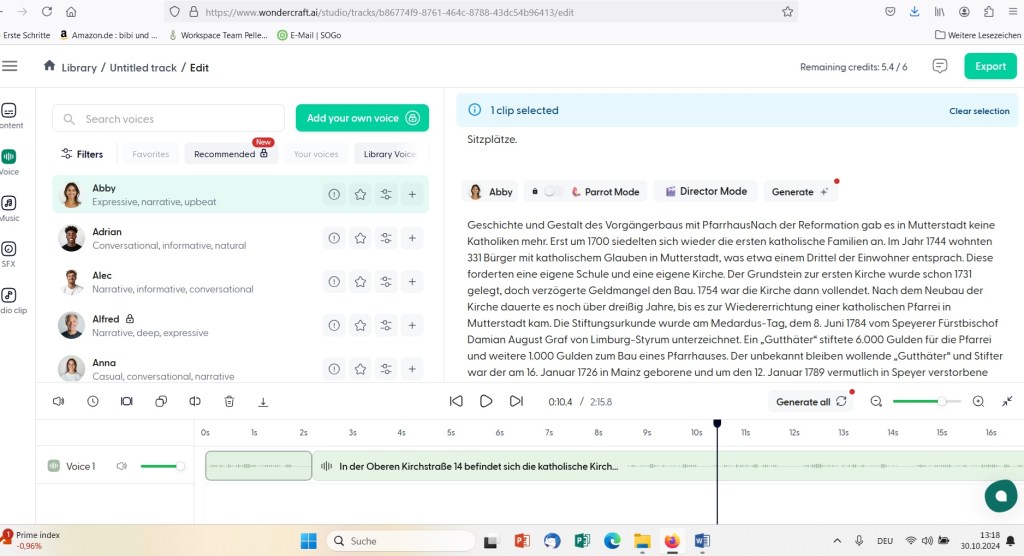

Ganz ähnlich verhält es sich mit der Anwendung Wondercraft. Auch diese kann man in der Testversion nutzen, um mit KI-Stimmen (in diesem Fall die KI Abby) Texte in Audiodateien umzuwandeln.

In manchen Sequenzen meint man eine Art Dialekt zu hören, in anderen aber klingt die Stimme eher normal. Das scheint zurzeit noch ein typisches Phänomen bei mit KI generierten Audios zu sein. Man muss ein wenig versuchen, bis man eine geeignete Stimme findet. Hier der Versuch mit einer männlichen Stimme (Alec) aus dem Wondercraft-Bestand:

Interessant ist die Option, dass man eine Datei der eigenen Stimme hochladen kann, um diese dann durch eine KI nutzbar zu machen. Inwiefern diese Option dann nutzbar ist, um mit Dialekt den Texten Lokalkolorit zu verleihen, ist noch zu erklären.

Solche künstlichen Stimmen können auch bei der Produktion von Tutorials eingesetzt werden, die wir in der nächsten Projektphase noch häufiger herstellen möchten – gegebenenfalls ergänzt um Videogenerierungsprogramme. Viele Universitäten setzen bereits auf solche Ki-erzeugten Audios und Videos bei der Vermittlung von grundlegendem Wissen.

Sicherlich ist es Geschmacksache, ob man der menschlichen oder der künstlichen Stimme den Vorzug gibt und manch einer findet den Gedanken bizarr, eine künstliche Stimme, die so menschlich wie möglich klingen soll, zu erstellen, wo es doch menschliche Stimmen in Hülle und Fülle gibt. Die Nutzung von neutral klingenden professionellen Stimmen, für die man lediglich eine schriftsprachliche Vorgabe formulieren muss, hat aber gewiss Vorzüge, etwa eine schnellere Produktion.

Ein unmittelbar einleuchtender Mehrwert von KI-Unterstützung ist die automatisierte Übersetzung von Texten in andere Sprachen. Hier leisten Programme wie DeepL inzwischen hervorragende Ergebnisse. Die übersetzten Texte kann man dann wiederum vertonen lassen.

Steinfiguren oder Portraitbilder zum Leben erwecken

Im Projektjahr 2021 wurden wir von unseren Partner:innen in der Pellenz gefragt, ob man nicht die Steinfigur des „Schrottelers“ zum Leben erwecken und animieren könnte. Damals war die Technologie noch nicht so weit – bzw. eine Umsetzung wäre so kostenintensiv gewesen, dass wir diese innovative Idee verwerfen mussten. Nun aber gibt es in diesem Jahr im Teilprojekt Sinzig / Bad Neuenahr-Ahrweiler im Zentrum von Bad Neuenahr die zwei Basaltfiguren „Hendrech on Jösef“. Und diese beiden Figuren nahmen wir zum Anlass, um erste Erfahrungen in Sachen Animation zu machen. Mithilfe von Adobe Photoshop haben wir ein paar ganz grobe Bewegungsabläufe der Figuren erstellt, die sich auf Bewegung der Arme, der Köpfe oder Beine beschränkt. Dann haben wir einen kurzen Text für ein Gespräch formuliert und mithilfe von elevenlabs vertont. Fotos, die beide Figuren frontal zeigen, und die erstellten Audiosequenzen haben wir dann in die Software D-iD (https://www.d-id.com/) geladen, welche beide Figuren lippensynchron animiert. Jede Sprechsequenz wird zu einer Datei. Das bedeutet, dass man für ein wechselseitiges Gespräch je ein Bild der Figur und eine Audiodatei hochladen muss, um eine Videodatei dann zu erhalten. Alle Videodateien wurden dann mithilfe eines Videoschnittprogramms wie Adobe Premiere oder (kostenlos) DaVinci mit den anderen Videosequenzen montiert, in denen sich die Figuren bewegen. Hier bieten sich in fast jeder Kommune solche Denkmäler, Statuen etc. an, um zum Beispiel wie in Bad Neuenahr augenzwinkernde Kommentare zu produzieren:

Möglich ist heute aber auch schon, historische, längst verstorbene Personen aufgrund von Fotos oder Gemälden zu reanimieren und sprechen zu lassen. Im Highend-Bereich ist das bereits annähernd fotorealistisch möglich, teilweise auch schon kombiniert mit dreidimensional wirkenden Hologrammen. Solche Möglichkeiten sind besonders interessant für eine anregende Vermittlung historischer Ereignisse oder Zusammenhänge. Daher werden wir diese Anwendungen in der nächsten Projektphase ausführlich testen.

Bilder mit KI generieren

Vielleicht erinnern Sie sich an das Titelbild eines vergangenen Beitrags, das sich gegenüber den üblichen Bildern auf unserer Seite abhob. Es zeigte eine romantisierte Flusslandschaft mit Schiffen, einer Burg auf einer Anhöhe und – im Bildvordergrund – einen Tisch mit Tortenstücken. Dieses Bild war ein KI-generiertes Bild der Webseite Bing.com. Wie bei vielen solchen Anbietern besteht über eine genaue schriftliche Beschreibung, was man sehen möchte, die Möglichkeit, ein solches Bild erstellen zu lassen, auch bezogen auf unterschiedliche Bildformate oder Kunststile. „Eine romantische Flusslandschaft, ähnlich dem Rhein, mit einer Burg auf der Anhöhe, im Vordergrund ein gedeckter Tisch mit Tortenstücken.“ So oder so ähnlich lautete der Prompt für dieses Bild. Allerdings würde das Ergebnis, wenn man jetzt erneut die gleiche Formulierung eingeben würde, anders aussehen. Die KI orientiert sich nämlich an einer Vielzahl von Bildern, die es zu Flüssen, Tälern, Burgen gibt und erstellt dann anhand dieser vielen Bilder ein „eigenes“ Produkt. Inwiefern es sich dabei um ein neues Werk handelt, ist aktuell Gegenstand ethischer und juristischer Debatten. Auch das Titelbild dieses Beitrags ist mit KI (Bing.com) und dem Promt „erstelle ein Bild das Menschen und Roboter gemeinsam in einer Stadt zeigt“erstellt worden.

Weitere Beispiele KI-generierter Bilder (generiert mit Bing)

Solche Bilder dienen uns bislang eher der Illustration, weniger der Wissensvermittlung, zumal einige der Bildgenerierungsprogramme wie Dall-E, Stable Diffusion oder Midjourney historische oder aktuelle Personen mit öffentlicher Bedeutung für eine Bearbeitung sperren. Wenn man eigene Fotografien oder historische Bilder als Basis hochlädt, kann man aber durchaus auch informative Funktionen damit verfolgen. So haben wir etwa bei unserem Eduventure zum Rheinübergang Blüchers Bildgenerierung mit 3D-Software kombiniert, um den Weg der 48.000 Soldaten über den Rhein zu animieren, von dem es ja keine historischen Dokumente gibt.

Fazit: KI produktiv, aber reflektiert nutzen

Die von uns genutzten Anwendungen sind alle recht einfach in ihrer Bedienbarkeit. Ein KI unterstützter Arbeitsvorgang könnte folgendermaßen aussehen: Ein längerer KuLaDig-Beitrag wird mittels KI, beispielsweise Chat-GPT, in eine kürzere, zielgruppenoptimierte Variante umformuliert. Dann wird mithilfe von Anwendungen wie elevenlabs aus dem Text ein Audio gemacht. Da wir in KuLaDig Audiodateien immer Bilder vorblenden, könnte mittels Bildgenerierung ein Foto erzeugt werden, das neugierig macht auf das im Audio behandelte Thema oder Objekt. Zudem kann man historische Orte oder Personen virtuell wiederauferstehen lassen, um Wissen noch anschaulicher zu vermitteln. Und all das lässt sich auch in virtuelle Räume integrieren, die man vor Ort an den Originalschauplätzen nutzen kann.

In der nächsten Projektphase möchten wir – unter dem Dach eines „KuLaDig-RLP-Campus“ – noch mehr in die Vermittlung solcher Techniken und Kompetenzen investieren und mit Tutorials oder Webinaren, ggf. auch in Veranstaltungen vor Ort, den Mitgliedern der lokalen Teams Wissen und Können vermitteln, um die positiven Mehrwerte von KI zu nutzen.

Das alles reduziert das menschliche Zutun an der Medienproduktion zunehmend. Dem Menschen obliegt es aber weiterhin, die Inhalte zu definieren und zu kontrollieren (in einem früheren Beitrag haben wir aufgezeigt, dass KI bei der Texterstellung noch sehr fehleranfällig arbeitet und daher eine gewissenhafte Kontrolle nötig ist). Ein wesentliches Thema bei der Nutzung von KI ist also nicht unbedingt die Handhabung, als vielmehr die Auswahl des Programms. Vielfach werben die Anbieter mit Testversionen. Diese aber ermöglichen nur eine begrenzte Anzahl an kostenlosen Medienproduktionen. Das heißt, wenn man eine größere Anzahl von Audios oder Animationen erstellen möchte, muss man Lizenzen für die Nutzung der einzelnen Produkte erwerben. Oder man macht es wie unsere Partner:innen in Herxheim und greift selbst zum Diktiergerät.

Ein Gedanke zu “KI-Einsatz bei der Präsentation kulturhistorischer Inhalte”